Теперь немного про нейронные сети. Обычно сложно интерпретировать как и почему нейронная сеть решила именно так. Я не сторонник полностью интерпретируемого машинного обучения в ущерб их эффективности, но иногда заглянуть в чёрный ящик полезно для разработки.

Например, когда сравнивают разные модели, обычно смотрится общая эффективность на каком-нибудь датасете, но общая оценка не показывает значимые отличая сетей.

В статье проводится обзор на примере задачи автодополнения поисковых запросов (или текста, когда вы набираете что-то на клавиатуре). В статье приходят к выводу, что GRU более ёмкая для запоминания long-term зависимостей, в сравнении с LSTM и Nested LSTM. Что лучше на практике, зависит от задачи, но понимание таких особенностей сетей очень помогает. Было очень бы интересно посмотреть, как запоминают современные модели и сравнить GRU с ELMO, BERT.

https://distill.pub/2019/memorization-in-rnns/

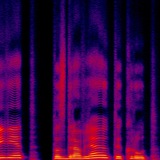

Интересный подход к визуализации "запоминания" в рекуррентных сетях. Как обычно, на distill очень красивые и интерактивные визуализации, хотя бы для этого стоит перейти по ссылке:)

#rnn #nn #sequences #paper

Например, когда сравнивают разные модели, обычно смотрится общая эффективность на каком-нибудь датасете, но общая оценка не показывает значимые отличая сетей.

В статье проводится обзор на примере задачи автодополнения поисковых запросов (или текста, когда вы набираете что-то на клавиатуре). В статье приходят к выводу, что GRU более ёмкая для запоминания long-term зависимостей, в сравнении с LSTM и Nested LSTM. Что лучше на практике, зависит от задачи, но понимание таких особенностей сетей очень помогает. Было очень бы интересно посмотреть, как запоминают современные модели и сравнить GRU с ELMO, BERT.

https://distill.pub/2019/memorization-in-rnns/

Интересный подход к визуализации "запоминания" в рекуррентных сетях. Как обычно, на distill очень красивые и интерактивные визуализации, хотя бы для этого стоит перейти по ссылке:)

#rnn #nn #sequences #paper

Distill

Visualizing memorization in RNNs

Inspecting gradient magnitudes in context can be a powerful tool to see when recurrent units use short-term or long-term contextual understanding.