На прошлой неделе google представили новую статью https://arxiv.org/abs/1810.04805 (BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding), и если кратко, то звучит многообещающе, но всё же дождёмся общедоступной реализации и, очень надеюсь, предобученных моделей.

В компьютерном зрении активно используется техника transfer learning, когда используется предобученная на большом объеме данных глубокая модель, для обучения для своей задачи. При внедрении машинного обучения в продакшен возникают стандартные проблемы:

- недостаточно данных

- недостаточно вычислительных мощностей

При том, проблема с мощностями решается гораздо проще нежели проблема данных и transfer learning в какой-то степени позволяет применить сложные модели для ваших задач не имея гигантского набора данных.

Так вот о чём это я, сейчас в NLP нет возможности эффективно применять transfer learning. А вот BERT может послужить решением этой проблемы, и тогда внедрение сильных NLP моделей упростится.

Здесь можете прочитать сжатое содержание публикации https://medium.com/syncedreview/best-nlp-model-ever-google-bert-sets-new-standards-in-11-language-tasks-4a2a189bc155

#google #nlp #future #paper

В компьютерном зрении активно используется техника transfer learning, когда используется предобученная на большом объеме данных глубокая модель, для обучения для своей задачи. При внедрении машинного обучения в продакшен возникают стандартные проблемы:

- недостаточно данных

- недостаточно вычислительных мощностей

При том, проблема с мощностями решается гораздо проще нежели проблема данных и transfer learning в какой-то степени позволяет применить сложные модели для ваших задач не имея гигантского набора данных.

Так вот о чём это я, сейчас в NLP нет возможности эффективно применять transfer learning. А вот BERT может послужить решением этой проблемы, и тогда внедрение сильных NLP моделей упростится.

Здесь можете прочитать сжатое содержание публикации https://medium.com/syncedreview/best-nlp-model-ever-google-bert-sets-new-standards-in-11-language-tasks-4a2a189bc155

#google #nlp #future #paper

Medium

Best NLP Model Ever? Google BERT Sets New Standards in 11 Language Tasks

The new Google AI paper BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding is receiving accolades from…

Удивительно полезный сайт для исследователей и практиков машинного обучения https://paperswithcode.com/ Как вы уже догадались из названия, там можно находить не только последние статьи, но и код. Сайт хорошо структурирован, можно легко найти нужные работы, есть рейтинги от пользователей.

Недавно появился ещё один раздел https://paperswithcode.com/sota, здесь собраны State-Of-The-Art решения для разных задач. Если нужно быстро вникнуть в новую задачу, это хорошая отправная точка. Находите SOTA решение похожей задачи, смотрите какие есть подходы и на каких датасетах оценивается результат и начинаете экспериментировать.

#code #paper #useful #sota #ml

Недавно появился ещё один раздел https://paperswithcode.com/sota, здесь собраны State-Of-The-Art решения для разных задач. Если нужно быстро вникнуть в новую задачу, это хорошая отправная точка. Находите SOTA решение похожей задачи, смотрите какие есть подходы и на каких датасетах оценивается результат и начинаете экспериментировать.

#code #paper #useful #sota #ml

huggingface.co

Trending Papers - Hugging Face

Your daily dose of AI research from AK

Теперь немного про нейронные сети. Обычно сложно интерпретировать как и почему нейронная сеть решила именно так. Я не сторонник полностью интерпретируемого машинного обучения в ущерб их эффективности, но иногда заглянуть в чёрный ящик полезно для разработки.

Например, когда сравнивают разные модели, обычно смотрится общая эффективность на каком-нибудь датасете, но общая оценка не показывает значимые отличая сетей.

В статье проводится обзор на примере задачи автодополнения поисковых запросов (или текста, когда вы набираете что-то на клавиатуре). В статье приходят к выводу, что GRU более ёмкая для запоминания long-term зависимостей, в сравнении с LSTM и Nested LSTM. Что лучше на практике, зависит от задачи, но понимание таких особенностей сетей очень помогает. Было очень бы интересно посмотреть, как запоминают современные модели и сравнить GRU с ELMO, BERT.

https://distill.pub/2019/memorization-in-rnns/

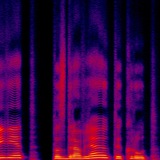

Интересный подход к визуализации "запоминания" в рекуррентных сетях. Как обычно, на distill очень красивые и интерактивные визуализации, хотя бы для этого стоит перейти по ссылке:)

#rnn #nn #sequences #paper

Например, когда сравнивают разные модели, обычно смотрится общая эффективность на каком-нибудь датасете, но общая оценка не показывает значимые отличая сетей.

В статье проводится обзор на примере задачи автодополнения поисковых запросов (или текста, когда вы набираете что-то на клавиатуре). В статье приходят к выводу, что GRU более ёмкая для запоминания long-term зависимостей, в сравнении с LSTM и Nested LSTM. Что лучше на практике, зависит от задачи, но понимание таких особенностей сетей очень помогает. Было очень бы интересно посмотреть, как запоминают современные модели и сравнить GRU с ELMO, BERT.

https://distill.pub/2019/memorization-in-rnns/

Интересный подход к визуализации "запоминания" в рекуррентных сетях. Как обычно, на distill очень красивые и интерактивные визуализации, хотя бы для этого стоит перейти по ссылке:)

#rnn #nn #sequences #paper

Distill

Visualizing memorization in RNNs

Inspecting gradient magnitudes in context can be a powerful tool to see when recurrent units use short-term or long-term contextual understanding.