QUANTAL COMPONENTS OF THE END-PLATE POTENTIAL (1954)

В современных вычислительной биологии модели зачастую идут параллельно с реальностью и не проверяются экспериментально должным образом: модель считается самодостаточным результатом. Данная работа, ставшая уже классической (>2000 цитат), демонстрирует то, как моделирование и эксперимент могут дополнять друг друга, в результате позволяя ответить на фундаментальные вопросы.

Del Castillo и Bernard Katz (нобелевский лауреат 1970-го) экспериментировали на лягушках, записывая токи с концевых мышечных пластинок и заметили, что если мотонейрон, аксон которого образовывал синапс с концевой пластинкой мышцы, спайковал, заливая всё ацетилхолином, то на пластинке регистрировался сильный деполяризующий отклик — потенциал концевой пластинки (end-plate potential или EPP) амплитудой в 20 mV (заряд смещался с -75mV до -55mV), однако, даже в отсутствии спайка на аксоне мотонейрона, на концевой пластинке регистрировались слабые потенциалы в 0.5 mV, которые было решено назвать миниатюрными потенциалами концевой пластинки (miniature end-plate potential или mEPP). Было предположено, что EPP = сумма большого числа mEPP случившихся в коротком временном интервале, где каждый mEPP – ответ на некоторый квант ацетилхолина, высвобождаемого пресинапсом. Стоит понимать, что про везикулы и синаптическую передачу тогда ничего толком не знали, поэтому квант – по факту одна условная везикула, случайно или неслучайно излившая содержимое в синаптическую щель. Тогда усредненная амплитуда EPP должна быть равна: V_e = npq, где n – число доступных квантов ацетилхолина в пресинапсе, а p – средняя вероятность высвобождения кванта (везикулы) в синаптическую щель, а q – амплитуда mEPP (в оригинале quantal amplitude). Собственно, вся статья 1954-го года посвящена проверке этой модели экспериментально. С этой целью ученые искусственно варьировали синаптическую проводимость, понижая концентрацию кальция (который нужен для высвобождения везикул, как мы сейчас знаем) и повышая магния, тем самым получив ответный EPP на спайк моторного нейрона амплитудой всего в несколько mV – несколько квантов или mEPP в рамках гипотезы. Если предложенная модель корректна, тогда среднее количество везикул-квантов высвобождаемых за каждый EPP должно быть равно m=np. При этом, условно зная (провидение), что число n везикул в пресинапсе большое, а вероятность экзоцитоза p маленькая, они предположили, что число везикул высвобождаемых в синаптическую щель должно аппроксимироваться Пуассоновским распределением, таким образом вероятность высвобождения x везикул-квантов в конкретном испытании равна P(x) = (m^x / x!) exp(-m). Это даёт два возможных способа получения числа m. Во-первых, это средняя амплитуда регистрируемого EPP, деленного на амплитуду q или mEPP. Во-вторых, экспериментальные условия приводили к тому, что регистрировалось множество нулевых EPP – когда никакого отклика на стимуляцию моторного нейрона в концевой пластинке не регистрировалось вследствие крайне малого значения p, что аналогично P(0) = exp(-m), а P(0) экспериментально можно получить как отношения числа неудач к общему числу испытаний. Если модель корректна, тогда оба этих пути оценки числа m должны давать идентичный результат m = mean(V_EPP)/q = ln(число испытаний/число неудач). Собственно, собрав данные они это и увидели. Такой квантовый анализ до сих пор используется в экспериментальной науке для анализа синаптических ответов, например, для локализации пре- и постсинаптических изменений связанных с LTP и LTD. И да, результаты этой работы во многом легли в основу современного знания о ВПСП и ТПСП в ЦНС, сама природа mEPP как бы намекает на сущностное родство.

В современных вычислительной биологии модели зачастую идут параллельно с реальностью и не проверяются экспериментально должным образом: модель считается самодостаточным результатом. Данная работа, ставшая уже классической (>2000 цитат), демонстрирует то, как моделирование и эксперимент могут дополнять друг друга, в результате позволяя ответить на фундаментальные вопросы.

Del Castillo и Bernard Katz (нобелевский лауреат 1970-го) экспериментировали на лягушках, записывая токи с концевых мышечных пластинок и заметили, что если мотонейрон, аксон которого образовывал синапс с концевой пластинкой мышцы, спайковал, заливая всё ацетилхолином, то на пластинке регистрировался сильный деполяризующий отклик — потенциал концевой пластинки (end-plate potential или EPP) амплитудой в 20 mV (заряд смещался с -75mV до -55mV), однако, даже в отсутствии спайка на аксоне мотонейрона, на концевой пластинке регистрировались слабые потенциалы в 0.5 mV, которые было решено назвать миниатюрными потенциалами концевой пластинки (miniature end-plate potential или mEPP). Было предположено, что EPP = сумма большого числа mEPP случившихся в коротком временном интервале, где каждый mEPP – ответ на некоторый квант ацетилхолина, высвобождаемого пресинапсом. Стоит понимать, что про везикулы и синаптическую передачу тогда ничего толком не знали, поэтому квант – по факту одна условная везикула, случайно или неслучайно излившая содержимое в синаптическую щель. Тогда усредненная амплитуда EPP должна быть равна: V_e = npq, где n – число доступных квантов ацетилхолина в пресинапсе, а p – средняя вероятность высвобождения кванта (везикулы) в синаптическую щель, а q – амплитуда mEPP (в оригинале quantal amplitude). Собственно, вся статья 1954-го года посвящена проверке этой модели экспериментально. С этой целью ученые искусственно варьировали синаптическую проводимость, понижая концентрацию кальция (который нужен для высвобождения везикул, как мы сейчас знаем) и повышая магния, тем самым получив ответный EPP на спайк моторного нейрона амплитудой всего в несколько mV – несколько квантов или mEPP в рамках гипотезы. Если предложенная модель корректна, тогда среднее количество везикул-квантов высвобождаемых за каждый EPP должно быть равно m=np. При этом, условно зная (провидение), что число n везикул в пресинапсе большое, а вероятность экзоцитоза p маленькая, они предположили, что число везикул высвобождаемых в синаптическую щель должно аппроксимироваться Пуассоновским распределением, таким образом вероятность высвобождения x везикул-квантов в конкретном испытании равна P(x) = (m^x / x!) exp(-m). Это даёт два возможных способа получения числа m. Во-первых, это средняя амплитуда регистрируемого EPP, деленного на амплитуду q или mEPP. Во-вторых, экспериментальные условия приводили к тому, что регистрировалось множество нулевых EPP – когда никакого отклика на стимуляцию моторного нейрона в концевой пластинке не регистрировалось вследствие крайне малого значения p, что аналогично P(0) = exp(-m), а P(0) экспериментально можно получить как отношения числа неудач к общему числу испытаний. Если модель корректна, тогда оба этих пути оценки числа m должны давать идентичный результат m = mean(V_EPP)/q = ln(число испытаний/число неудач). Собственно, собрав данные они это и увидели. Такой квантовый анализ до сих пор используется в экспериментальной науке для анализа синаптических ответов, например, для локализации пре- и постсинаптических изменений связанных с LTP и LTD. И да, результаты этой работы во многом легли в основу современного знания о ВПСП и ТПСП в ЦНС, сама природа mEPP как бы намекает на сущностное родство.

Forwarded from Алексей Хохлов

Вопрос о том, как могло возникнуть такое удивительное явление, которое мы называем «жизнь», является одним из наиболее фундаментальных вызовов для современного естествознания. Похоже, что в истекающем месяце мы продвинулись на один шаг к пониманию этого явления. 4 марта в PNAS опубликована статья Джеральда Джойса с соавторами (Институт биологических исследований Солка, США), в которой впервые удалось получить весомые доказательства возможности элементарных процессов «РНК-жизни».

Согласно современным воззрениям, исходные молекулярные процессы, которые впоследствии развились в явление «жизни», происходили в «РНК-мире», где еще не было ни молекул белков, ни ДНК, существовали лишь молекулы РНК, которые выполняли как функции хранения информации, так и функции катализа важных для процессов «жизни» реакций. В опубликованной Д.Джойсом с соавторами работе удалось получить рибозим-полимеразу (молекулу РНК, размножающую рибозимы, т.е. катализаторы на основе РНК) с такой точностью, что способность к катализу не только не теряется, но улучшается в каждом следующем поколении.

Таким образом, продемонстрирована возможность дарвиновской эволюции в «РНК-мире» без какого-либо участия белковых ферментов. В каждом следующем поколении происходит накопление полезных мутаций и рост «приспособленности» размножаемых молекул. Следующим шагом должно стать достижение такой точности синтеза, который позволил бы рибозим-полимеразам воспроизводить самих себя. Думаю, что накопленный в группе Д.Джойса объем «big data» (он работает в этой области около 30 лет) мог бы позволить применить для этой решения этой проблемы инструменты искусственного интеллекта.

С подробностями обсуждаемой работы можно ознакомиться по содержательному очерку Александра Маркова на elementy.ru:

https://elementy.ru/novosti_nauki/434208/Evolyutsiya_ribozimov_razmnozhaemykh_ribozimami_eshche_odin_shag_k_vossozdaniyu_RNK_zhizni_v_probirke/t379113/Aleksandr_Markov

А вот ссылка на оригинальную статью Д.Джойса с соавторами:

https://www.pnas.org/doi/10.1073/pnas.2321592121

Согласно современным воззрениям, исходные молекулярные процессы, которые впоследствии развились в явление «жизни», происходили в «РНК-мире», где еще не было ни молекул белков, ни ДНК, существовали лишь молекулы РНК, которые выполняли как функции хранения информации, так и функции катализа важных для процессов «жизни» реакций. В опубликованной Д.Джойсом с соавторами работе удалось получить рибозим-полимеразу (молекулу РНК, размножающую рибозимы, т.е. катализаторы на основе РНК) с такой точностью, что способность к катализу не только не теряется, но улучшается в каждом следующем поколении.

Таким образом, продемонстрирована возможность дарвиновской эволюции в «РНК-мире» без какого-либо участия белковых ферментов. В каждом следующем поколении происходит накопление полезных мутаций и рост «приспособленности» размножаемых молекул. Следующим шагом должно стать достижение такой точности синтеза, который позволил бы рибозим-полимеразам воспроизводить самих себя. Думаю, что накопленный в группе Д.Джойса объем «big data» (он работает в этой области около 30 лет) мог бы позволить применить для этой решения этой проблемы инструменты искусственного интеллекта.

С подробностями обсуждаемой работы можно ознакомиться по содержательному очерку Александра Маркова на elementy.ru:

https://elementy.ru/novosti_nauki/434208/Evolyutsiya_ribozimov_razmnozhaemykh_ribozimami_eshche_odin_shag_k_vossozdaniyu_RNK_zhizni_v_probirke/t379113/Aleksandr_Markov

А вот ссылка на оригинальную статью Д.Джойса с соавторами:

https://www.pnas.org/doi/10.1073/pnas.2321592121

Элементы

Эволюция рибозимов, размножаемых рибозимами: еще один шаг к воссозданию РНК-жизни в пробирке

Одним из важнейших этапов развития РНК-жизни было появление рибозимов-полимераз (молекул РНК, размножающих молекулы РНК), достаточно точных, чтобы полезная наследственная информация не терялась, а накапливалась в ряду поколений. До сих пор экспериментаторам…

MLP vs KAN (обучаем не веса, но функции активации)

KAN: Kolmogorov–Arnold Networks

что хорошо:

1. Генерализация и интерпретируемость сильно лучше

2. Возможность "дообучить" сеть без добавления новых слоев и обучения по-новой

3. Т.к. суть новой архитектуры в аппроксимации сложных функций, а не подборе чисел в вектора весов, то KAN, судя по всему, хорошо решает диффуры

что плохо:

1. Обучается медленнее MLP в десятки раз (т.к. обучение не на GPU)

2. Пока не ясно, насколько она действительно лучше на сложных бенчмарках

3. При равном числе нейронов в MLP и KAN, последняя требует больше параметров

тут можно целых полтора часа слушать первого автора (Ziming Liu) про статью

KAN: Kolmogorov–Arnold Networks

что хорошо:

1. Генерализация и интерпретируемость сильно лучше

2. Возможность "дообучить" сеть без добавления новых слоев и обучения по-новой

3. Т.к. суть новой архитектуры в аппроксимации сложных функций, а не подборе чисел в вектора весов, то KAN, судя по всему, хорошо решает диффуры

что плохо:

1. Обучается медленнее MLP в десятки раз (т.к. обучение не на GPU)

2. Пока не ясно, насколько она действительно лучше на сложных бенчмарках

3. При равном числе нейронов в MLP и KAN, последняя требует больше параметров

тут можно целых полтора часа слушать первого автора (Ziming Liu) про статью

В мл часто встречается прием, когда к матрице добавляют на диагональ чутка шума, чтобы у нее точно существовала обратная, т.е., произвольная матрица A может быть вырожденной, но если мы хотим решить задачу, в которой необходима A^-1, то можно найти (A+epsilon*I)^-1, которая точно существует для A+epsilon*I, но почему?

Теорема Сарда: пусть M и N это гладкие многообразия (с границей или без) и F: M—>N гладкое отобр. Тогда множество критических значений F имеет меру 0 в N (множество образов критических точек из M).

Связь с мл-магией следующая: пусть det: M_n(R) —> R, где M_n(R) пространство вещественнозначных матриц n x n (это гладкие многообразия, а det — гладкая функция). Матрица A вырождена, если она является критическим значением det, тогда множество таких матриц имеет меру нуль (по теореме Сарда) и его дополнение GL_n(R) всюду плотно в M_n(R). Поэтому добавление эпсилон-шума почти наверняка (с вероятностью 1) даст нам матрицу из GL_n(R) у которой уже есть обратная.

(по факту, достаточно знать, что множество нулей аналитической функции имеет меру нуль и теорема Сарда не нужна)

Теорема Сарда: пусть M и N это гладкие многообразия (с границей или без) и F: M—>N гладкое отобр. Тогда множество критических значений F имеет меру 0 в N (множество образов критических точек из M).

Связь с мл-магией следующая: пусть det: M_n(R) —> R, где M_n(R) пространство вещественнозначных матриц n x n (это гладкие многообразия, а det — гладкая функция). Матрица A вырождена, если она является критическим значением det, тогда множество таких матриц имеет меру нуль (по теореме Сарда) и его дополнение GL_n(R) всюду плотно в M_n(R). Поэтому добавление эпсилон-шума почти наверняка (с вероятностью 1) даст нам матрицу из GL_n(R) у которой уже есть обратная.

(по факту, достаточно знать, что множество нулей аналитической функции имеет меру нуль и теорема Сарда не нужна)

Empty Set of Ideas

MLP vs KAN (обучаем не веса, но функции активации) KAN: Kolmogorov–Arnold Networks что хорошо: 1. Генерализация и интерпретируемость сильно лучше 2. Возможность "дообучить" сеть без добавления новых слоев и обучения по-новой 3. Т.к. суть новой архитектуры…

интересно, конечно, какой класс функций приближают такие KAN-сети, т.к. аналога теоремы KA для гладких функций нет, а они пользуются именно ими

История идеалов

Иногда сталкиваешься с непониманием, почему то или иное определение показалось людям естественным. В отличие от андерград курсов алгебры, где идеалы просто определяются или вводятся как ядра кольцевых гомоморфизмов, историческое появление идеалов связывают с алгебраической теорией чисел и великой теоремой Ферма: понятие "идеал" происходит от "идеальных чисел" Куммера, который занимался вопросами делимости алгебраических целых чисел и обнаружил неоднозначность их разложения на простые множители: скажем, в подкольце целых алгебраических чисел Z[\sqrt{-5}] число 6 = 2 * 3 = (1-\sqrt{-5})(1+\sqrt{-5}), причём в обоих случаях все множители — простые, то есть неразложимы в этом подкольце. Идея Куммера состояла в том, что существуют некие идеальные числа, которые дадут однозначное разложение уж точно наверняка всегда. Другой подход предложил Дедекинд, который решил не пытаться построить множество идеальных чисел, но рассмотреть множества таких чисел, которые бы на них делились, например, не 2, но множество четных чисел. Дедекинд заметил, что понятие "делиться на" обладает следующими свойствами:

1. Если некоторое число (идеальное или нет) делит a и b, то делит и a+b

2. Если некоторое число делит a, то делит и кратные \lambda * a

Так что идеалы Дедекинд определил через эти два свойства. Их оказалось достаточно, чтобы затем ввести понятие Дедекиндова кольца и разобраться с делимостью алгебраических чисел.

Можно про это подробнее почитать в статье ISRAEL KLEINER "The Roots of Commutative Algebra in Algebraic Number Theory"

Иногда сталкиваешься с непониманием, почему то или иное определение показалось людям естественным. В отличие от андерград курсов алгебры, где идеалы просто определяются или вводятся как ядра кольцевых гомоморфизмов, историческое появление идеалов связывают с алгебраической теорией чисел и великой теоремой Ферма: понятие "идеал" происходит от "идеальных чисел" Куммера, который занимался вопросами делимости алгебраических целых чисел и обнаружил неоднозначность их разложения на простые множители: скажем, в подкольце целых алгебраических чисел Z[\sqrt{-5}] число 6 = 2 * 3 = (1-\sqrt{-5})(1+\sqrt{-5}), причём в обоих случаях все множители — простые, то есть неразложимы в этом подкольце. Идея Куммера состояла в том, что существуют некие идеальные числа, которые дадут однозначное разложение уж точно наверняка всегда. Другой подход предложил Дедекинд, который решил не пытаться построить множество идеальных чисел, но рассмотреть множества таких чисел, которые бы на них делились, например, не 2, но множество четных чисел. Дедекинд заметил, что понятие "делиться на" обладает следующими свойствами:

1. Если некоторое число (идеальное или нет) делит a и b, то делит и a+b

2. Если некоторое число делит a, то делит и кратные \lambda * a

Так что идеалы Дедекинд определил через эти два свойства. Их оказалось достаточно, чтобы затем ввести понятие Дедекиндова кольца и разобраться с делимостью алгебраических чисел.

Можно про это подробнее почитать в статье ISRAEL KLEINER "The Roots of Commutative Algebra in Algebraic Number Theory"

Empty Set of Ideas

An Efficient Algorithm for 1-Dimensional (Persistent) Path Homology (2022) В данной статье предлагается улучшение существующего алгоритма подсчета путевых гомологий в размерности 1. Например, для планарных графов сложность подсчета 1-х путевых гомологий с…

Идея путевых гомологий может показаться немного искусственной, но даже у такой конструкции есть вполне интуитивные предпосылки. Суть в существовании двух функторов U, Flag между категориями SimpComplex и Poset. Каждый симплекс комплекса K предстает вершиной в орграфе, где ребрам соответствует отношение включения. Это задается функтором U, обратный функтор Flag строит по орграфу симплициальный комплекс B(K), который является барицентрическим подразделение изначального, т.е. комплексом, p-1-симплексы которого — p-пути орграфа. Такие пути образуют флаги в изначальном комплексе, например 3-путь вида: вершина — ребро — 2-симплекс, упорядоченные по включению. Этот путь в орграфе U(K) или флаг в K образует 2-симплекс в новом комплексе B(K). Важно, что гомотопический тип сохраняется при таком подразделении, т.е. по орграфовому одномерному представлению можно в обратную сторону восстановить топологию комплекса, на который действовал функтор U.

B(K) = Flag(U(K)), где B – барицентрическое подразделение К. То есть, еще раз, есть два функтора, которые описывают переход от комплексов к орграфам и назад без потери информации о гомотопическом типе.

В построении путевых гомологий первым шагом является определение линейного пространства формальных комбинаций p-путей, для которых дальше уже определяется оператор взятия границы и все привычные гомоштуки, а дальше доказывают крутые свойства типа формулы Кюннета.

B(K) = Flag(U(K)), где B – барицентрическое подразделение К. То есть, еще раз, есть два функтора, которые описывают переход от комплексов к орграфам и назад без потери информации о гомотопическом типе.

В построении путевых гомологий первым шагом является определение линейного пространства формальных комбинаций p-путей, для которых дальше уже определяется оператор взятия границы и все привычные гомоштуки, а дальше доказывают крутые свойства типа формулы Кюннета.

Forwarded from Такие себе мысли

Топология бассейна притяжения

Lets switch gears

Есть очень красивый чисто топологический сюжет, описанный Ветровым.

Вот есть машобуч. В нем как правило надо подогнать какие-то параметры, так чтобы функция, заданная с помощью этих параметров хорошо интерполировала/экстраполировала обучающую выборку. Как правило это решается введением лосса - функции потерь, и минимизации этой функции методом градиентного спуска (или какими-нибудь инженерными свистелками, вроде стохастического градиента).

С одной стороны, градиентный спуск - это превосходная вещь, интерпретируемая, легко прогается, связана с хорошей математикой вроде теории Морса. С другой стороны, мы учим студентов быть осторожными: если стоит задача найти глобальный минимум, то градиентный спуск может быть плохим помощником - вдруг мы свалимся в неправильный локальный минимум?

И тут приходят машинщики и такие говорят "Мы применяем градиентный спуск, и он прямо очень хорошо работает, лучше, чем ожидается. Мы не сваливаемся в плохие локальные минимумы (где лосс маленький на трейне, и большой на тесте), а те, в которые сваливаемся - они прямо очень похожи на глобальные." Почему так? Полного ответа нет, но есть интересное наблюдение.

Для функции f:R^d-->R (стремящейся к +∞ при x-->∞ и с глобальным минимумом 0 для простоты) рассмотрим фильтрацию подуровня

LS(t)={x|f(x)<t},

lower set filtration, прямо как в топологическом анализе данных. Затапливаем график функции водой грубо говоря.

И вот интуиция из матана, теории Морса и т.д. нам говорит, что при увеличении t вначале - в момент t=0 - возникнет озеро вокруг точки глобального минимума, потом возникнет озеро где-то в другом месте - в неправильном локальном минимуме, возникнут еще сколько-то озер. Потом, когда параметр t начнет проходить через критические значения в седловых точках, наши озера начнут объединяться в озера побольше и т.д.

Однако, если размерность d равна 100500 триллионов, то картинка происходящего будет другой. При затоплении за очень малое время возникнут гуголы локальных минимумов, которые в это же самое время слипнутся в связный кластер. Концептуально это довольно понятно: морсовских значений должно быть настолько дохрена, что любой отрезок [0,ε] содержит как кучу значений индекса 0, так и кучу значений индекса 1, перестройки на которых сразу же соединяют болота в минимумах.

Математически - есть про это интересные работы, например вот тут https://arxiv.org/abs/1110.5872 злой матан. Обсуждают про связь этих эффектов со спиновыми стёклами.

Практически, есть работа Ветрова https://arxiv.org/abs/1802.10026 где показано, что если взять два случайных минимума функции потерь большой модели, то между ними можно проложить путь, целиком проходящий "по минимумам". Говоря иначе, множество LS(ε) при малых ε - связно. Более того, в качестве пути можно тупо взять двузвенную ломаную.

Это всё, конечно, не означает, что теория Морса не работает. Но это означает, что на больших размерностях и "компьютерных" порядках малости теория Морса может дать неверные интуиции о происходящем.

Lets switch gears

Есть очень красивый чисто топологический сюжет, описанный Ветровым.

Вот есть машобуч. В нем как правило надо подогнать какие-то параметры, так чтобы функция, заданная с помощью этих параметров хорошо интерполировала/экстраполировала обучающую выборку. Как правило это решается введением лосса - функции потерь, и минимизации этой функции методом градиентного спуска (или какими-нибудь инженерными свистелками, вроде стохастического градиента).

С одной стороны, градиентный спуск - это превосходная вещь, интерпретируемая, легко прогается, связана с хорошей математикой вроде теории Морса. С другой стороны, мы учим студентов быть осторожными: если стоит задача найти глобальный минимум, то градиентный спуск может быть плохим помощником - вдруг мы свалимся в неправильный локальный минимум?

И тут приходят машинщики и такие говорят "Мы применяем градиентный спуск, и он прямо очень хорошо работает, лучше, чем ожидается. Мы не сваливаемся в плохие локальные минимумы (где лосс маленький на трейне, и большой на тесте), а те, в которые сваливаемся - они прямо очень похожи на глобальные." Почему так? Полного ответа нет, но есть интересное наблюдение.

Для функции f:R^d-->R (стремящейся к +∞ при x-->∞ и с глобальным минимумом 0 для простоты) рассмотрим фильтрацию подуровня

LS(t)={x|f(x)<t},

lower set filtration, прямо как в топологическом анализе данных. Затапливаем график функции водой грубо говоря.

И вот интуиция из матана, теории Морса и т.д. нам говорит, что при увеличении t вначале - в момент t=0 - возникнет озеро вокруг точки глобального минимума, потом возникнет озеро где-то в другом месте - в неправильном локальном минимуме, возникнут еще сколько-то озер. Потом, когда параметр t начнет проходить через критические значения в седловых точках, наши озера начнут объединяться в озера побольше и т.д.

Однако, если размерность d равна 100500 триллионов, то картинка происходящего будет другой. При затоплении за очень малое время возникнут гуголы локальных минимумов, которые в это же самое время слипнутся в связный кластер. Концептуально это довольно понятно: морсовских значений должно быть настолько дохрена, что любой отрезок [0,ε] содержит как кучу значений индекса 0, так и кучу значений индекса 1, перестройки на которых сразу же соединяют болота в минимумах.

Математически - есть про это интересные работы, например вот тут https://arxiv.org/abs/1110.5872 злой матан. Обсуждают про связь этих эффектов со спиновыми стёклами.

Практически, есть работа Ветрова https://arxiv.org/abs/1802.10026 где показано, что если взять два случайных минимума функции потерь большой модели, то между ними можно проложить путь, целиком проходящий "по минимумам". Говоря иначе, множество LS(ε) при малых ε - связно. Более того, в качестве пути можно тупо взять двузвенную ломаную.

Это всё, конечно, не означает, что теория Морса не работает. Но это означает, что на больших размерностях и "компьютерных" порядках малости теория Морса может дать неверные интуиции о происходящем.

Why can't you tickle yourself? (2000)

Уже ставшая классической работа с 1000+ цитирований про механизмы обратной связи, регулирующей восприятие согласно информации о наших собственных движениях. Существует предсказательная модель, которая говорит нам, что тот или иной сенсорный опыт важен, где важность опыта пропорциональна его новизне для организма: чем более неожиданный сенсорный сигнал мы получаем, тем больше внимания на него обращаем. Когда же мы щекочим себя сами, то новизна опыта стремится к нулю, так как мы с точностью можем предсказать данный сенсорный опыт. В статье они посмотрели на активность соматосенсорной коры (и еще пары областей), которая значительно падала в моменты самощекотания и наоборот при щекотании испытуемых кем-то.

Уже ставшая классической работа с 1000+ цитирований про механизмы обратной связи, регулирующей восприятие согласно информации о наших собственных движениях. Существует предсказательная модель, которая говорит нам, что тот или иной сенсорный опыт важен, где важность опыта пропорциональна его новизне для организма: чем более неожиданный сенсорный сигнал мы получаем, тем больше внимания на него обращаем. Когда же мы щекочим себя сами, то новизна опыта стремится к нулю, так как мы с точностью можем предсказать данный сенсорный опыт. В статье они посмотрели на активность соматосенсорной коры (и еще пары областей), которая значительно падала в моменты самощекотания и наоборот при щекотании испытуемых кем-то.

Про функторы и кластеризацию

В работе "An Impossibility Theorem for Clustering" (2002) Jon Kleinberg определяет три простых свойства, которым должна удовлетворять любая кластеризация, а затем доказывает, что ни один алгоритм кластеризации не может обладать всеми тремя свойствами одномоментно. Пусть дано множество S, состоящие из n ≥ 2 точек и некоторая полуметрика (без неравенства треугольника) на нем d:S×S→R. Пусть D(S) — множество полуметрик на S, а Π(S) — множество разбиений S на дизъюнктные подмножества. Тогда кластеризацией назовем функцию f: D(S) → Π(S), которая каждой полуметрике на S ставит в соответствие некоторое диз.разбиение. Kleinberg предложил следующие три свойства, которым должна отвечать каждая такая функция f:

1. Инвариантность относительно гомотетии (scale invariance): f(d) = f(alpha * d) для любых d из D(S) и alpha > 0 из R;

2. Насыщенность (?) или richness: f сюръекция;

3. Непротиворечивость или consistency: пусть есть две полуметрики d и d', а Г некоторое разбиение S. d' это Г-трансформация d, если d'(i,j)≤d(i,j) для всех пар из одного кластера в Г, аналогично d'(i,j) ≥ d(i,j) для всех пар в различных кластерах, тогда d и d' не противоречат друг друг, если d' это f(d) трансформация d, то f(d) = f(d'), т.е. кластеры уплотняются и расползаются при замене метрики d на d';

Существуют алгоритмы кластеризации, которые сочетают в себе любые 2 из 3 перечисленных свойств. Допустим S — множество вершина графа, а d(i,j) — вес ребра. Рассмотрим три функции кластеризации, которые находят подграфы, выбирая некоторое подмножество ребер:

1. выберем произвольное 1<k<n и упорядочим ребра по весу, будем добавлять ребра в подграф из упорядоченного списка ребер, пока он не будет иметь ровно k связных компонент;

2. выберем произвольное r и будем добавлять ребра с весом не меньшим r, полученные компоненты связности и назовем кластерами;

3. выберем произвольное 1 > alpha > 0 и пусть R это max(d). Будем сохранять ребра с весом не более alpha * d;

Утверждение: Функция 1 удовлетворяет 1 и 3 (число кластеров ограничено k сверху), функция 2 удовлетворяет 2 и 3 (варьируем r, получаем разные разбиения и теряем инвариантность относительно гомотетии), а функция 3 удовлетворяет 1 и 2.

И тут в дело врывается топологический анализ данных, с уже классической статьей "Classifying Clustering Schemes" (2013) by Gunnar Carlsson & Facundo Memoli. Ключевая идея их работы заключается в том, что эти свойства кластеризации могут быть закодированы как морфизмы в категории конечных метрических пространств таким образом, что ответом будет не функция кластеризации, а функтор кластеризации в подходящую категорию и он будет обладать уже всеми желанными свойствами.

В работе "An Impossibility Theorem for Clustering" (2002) Jon Kleinberg определяет три простых свойства, которым должна удовлетворять любая кластеризация, а затем доказывает, что ни один алгоритм кластеризации не может обладать всеми тремя свойствами одномоментно. Пусть дано множество S, состоящие из n ≥ 2 точек и некоторая полуметрика (без неравенства треугольника) на нем d:S×S→R. Пусть D(S) — множество полуметрик на S, а Π(S) — множество разбиений S на дизъюнктные подмножества. Тогда кластеризацией назовем функцию f: D(S) → Π(S), которая каждой полуметрике на S ставит в соответствие некоторое диз.разбиение. Kleinberg предложил следующие три свойства, которым должна отвечать каждая такая функция f:

1. Инвариантность относительно гомотетии (scale invariance): f(d) = f(alpha * d) для любых d из D(S) и alpha > 0 из R;

2. Насыщенность (?) или richness: f сюръекция;

3. Непротиворечивость или consistency: пусть есть две полуметрики d и d', а Г некоторое разбиение S. d' это Г-трансформация d, если d'(i,j)≤d(i,j) для всех пар из одного кластера в Г, аналогично d'(i,j) ≥ d(i,j) для всех пар в различных кластерах, тогда d и d' не противоречат друг друг, если d' это f(d) трансформация d, то f(d) = f(d'), т.е. кластеры уплотняются и расползаются при замене метрики d на d';

Существуют алгоритмы кластеризации, которые сочетают в себе любые 2 из 3 перечисленных свойств. Допустим S — множество вершина графа, а d(i,j) — вес ребра. Рассмотрим три функции кластеризации, которые находят подграфы, выбирая некоторое подмножество ребер:

1. выберем произвольное 1<k<n и упорядочим ребра по весу, будем добавлять ребра в подграф из упорядоченного списка ребер, пока он не будет иметь ровно k связных компонент;

2. выберем произвольное r и будем добавлять ребра с весом не меньшим r, полученные компоненты связности и назовем кластерами;

3. выберем произвольное 1 > alpha > 0 и пусть R это max(d). Будем сохранять ребра с весом не более alpha * d;

Утверждение: Функция 1 удовлетворяет 1 и 3 (число кластеров ограничено k сверху), функция 2 удовлетворяет 2 и 3 (варьируем r, получаем разные разбиения и теряем инвариантность относительно гомотетии), а функция 3 удовлетворяет 1 и 2.

И тут в дело врывается топологический анализ данных, с уже классической статьей "Classifying Clustering Schemes" (2013) by Gunnar Carlsson & Facundo Memoli. Ключевая идея их работы заключается в том, что эти свойства кластеризации могут быть закодированы как морфизмы в категории конечных метрических пространств таким образом, что ответом будет не функция кластеризации, а функтор кластеризации в подходящую категорию и он будет обладать уже всеми желанными свойствами.

Рассмотрим две категории: FinMetric конечных метрических пространств с морфизмами монотонными невозрастающими функциями и категорию Cluster состоящую из разбиений на кластеры S и морфизмов-подразбиений. Carlsson и Mémoli обнаружили, что единственные инвариантные относительно гомотетии функторы между FinMetric → Cluster это тривиальные разбиения на дискретные одноэлементные кластеры (число кластеров = числу точек в объекте) или антидискретное разбиение в один кластер, состоящий из всех объектов. Оба функтора не удовлетворяли условию 2 на сюръективность алгоритма кластеризации их статьи Клейнберга. Поэтому авторы решили заменить кластеры в привычном смысле на новый объект – персистентные кластеры. Персистентный кластер на S это функтор из частично-упорядоченной категории ([0, ∞), ≤) в чум кластеров на S, где φ ≤ ψ iff разбиение φ получается уточнением/подразбиением разбиения ψ. Идея состоит в том, что когда параметр r ∈ [0, ∞) мал, разбиение S может быть очень грубым и близким к дискретному, но кластерам разрешено расти при варьировании параметра r. Вместо категории Cluster необходимо рассматривать категорию PCluster, чьи объекты это уже персистентные кластеры, а морфизмы аналогичны морфизмам в Cluster, но для каждого выбранного r ∈ [0, ∞). Carlsson и Mémoli доказали, что существует единственный функтор из FinMet в PCluster, который удовлетворяет всем трем свойствам из статьи Клейнберга.

Classifying Clustering Schemes 2013.pdf

1.1 MB

Статья Gunnar Carlsson и Facundo Mémoli

Forwarded from Математическая свалка Сепы (Sergei)

От моноидов к ∞-монадам

Один коллега вовлёк меня в проект, где мне нужно пользоваться ∞-категориями, и ∞-монадами. В меня как-то ∞-монады с трудом заходили, и это побудило меня начать писать этот пост. Замысел был в том, чтобы рассказать про то, как идея моноида развивается на разных уровнях: обычный моноид, моноид в категории, моноидальная категория, моноид в моноидальной категории, монада, моноидальная ∞-категория, моноид в моноидальной ∞-категории, ∞-монада. Хотелось красиво показать, что это такая непрерывная спираль развития идей, в которой предыдущий этаж необходим для следующего. Однако в процессе написания этого поста я узнал, что есть эквивалентное определение ∞-монады, для которого не обязательно знать, что такое моноидальная ∞-категория. К тому моменту пост уже был очень большим, и мне он показался какой-то совершенно бессмысленной графоманией, и я передумал его постить. Но потом я вспомнил, что группа называется свалкой, и решил его запостить всё равно. Можете считать, что это что-то типа дневника моих попыток понять, что такое ∞-монада, и просто рассуждения на тему моноидального.

∙ Моноиды

∙ Моноидальные категории

∙ Моноиды в моноидальных категориях

∙ Монады

∙ Ходячий моноид

∙ О бухгалтерском учёте

∙ Расслоения Гротендика

∙ Псевдофункторы и расслоения

∙ Моноидальные категории как оп-расслоения

∙ Моноиды как сечения оп-расслоений

∙ Выпрямление-развыпрямление

∙ Моноидальные ∞-категории и моноиды в них

∙ Моноидальная ∞-категория эндофункторов

∙ ∞-монады

∙ Список литературы

https://medium.com/@ivanov.s.o.1986/от-моноидов-к-монадам-46cac1e0fae6

Один коллега вовлёк меня в проект, где мне нужно пользоваться ∞-категориями, и ∞-монадами. В меня как-то ∞-монады с трудом заходили, и это побудило меня начать писать этот пост. Замысел был в том, чтобы рассказать про то, как идея моноида развивается на разных уровнях: обычный моноид, моноид в категории, моноидальная категория, моноид в моноидальной категории, монада, моноидальная ∞-категория, моноид в моноидальной ∞-категории, ∞-монада. Хотелось красиво показать, что это такая непрерывная спираль развития идей, в которой предыдущий этаж необходим для следующего. Однако в процессе написания этого поста я узнал, что есть эквивалентное определение ∞-монады, для которого не обязательно знать, что такое моноидальная ∞-категория. К тому моменту пост уже был очень большим, и мне он показался какой-то совершенно бессмысленной графоманией, и я передумал его постить. Но потом я вспомнил, что группа называется свалкой, и решил его запостить всё равно. Можете считать, что это что-то типа дневника моих попыток понять, что такое ∞-монада, и просто рассуждения на тему моноидального.

∙ Моноиды

∙ Моноидальные категории

∙ Моноиды в моноидальных категориях

∙ Монады

∙ Ходячий моноид

∙ О бухгалтерском учёте

∙ Расслоения Гротендика

∙ Псевдофункторы и расслоения

∙ Моноидальные категории как оп-расслоения

∙ Моноиды как сечения оп-расслоений

∙ Выпрямление-развыпрямление

∙ Моноидальные ∞-категории и моноиды в них

∙ Моноидальная ∞-категория эндофункторов

∙ ∞-монады

∙ Список литературы

https://medium.com/@ivanov.s.o.1986/от-моноидов-к-монадам-46cac1e0fae6

Medium

От моноидов к ∞-монадам

Математическая свалка Сепы

Forwarded from Математическая свалка Сепы (Sergei)

от_моноидов_к_бесконечность_монадам.pdf

494.6 KB

Предыдущий пост "От моноидов к ∞-монадам" в виде pdf.

Forwarded from Alexander C

This media is not supported in your browser

VIEW IN TELEGRAM

🚀 Уважаемые коллеги, тех, кому интересна математика и машинное обучение, приглашаем Вас принять в неформальном проекте.

Минимальное требование - Вы знакомы с Питоном, и у Вас есть несколько часов свободного времени в неделю. (Альтернативно - можно не знать Питон, но хорошо знать теорию групп (в идеале GAP,SAGE).) Задача проекта - применить машинное обучение к теории групп. Целью проекта является написание статьи в хорошем журнале, участники - соавторы. Другим бонусом будет являться - приобретение навыков по современным методам нейронных сетей, Reinforcement Learning и т.д.

Если Вам интересно участие - напишите @alexander_v_c (Александр Червов, к.ф.-м.н. мехмат МГУ, 25 лет math&DS, Kaggle, Scholar, Linkedin).

Чат для обсуждений: тут .

Вводный доклад тут.

Пояснения по RL части тут.

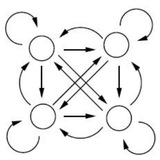

Краткая суть задачи может быть описана несколькими способами - нахождение пути на графе от вершины А до вершины Б, но размер графа 10^20-10^50 - обычные методы не применимы. Решение пазла типа Кубика Рубика. Задача близка к прошедшему конкурсу Каггл Санта 2023. Математически - разложение элемента группы по образующим. Математические пакеты, которые частично могут решать эту задачу - GAP,SAGE.

Достигнутые результаты - уже сейчас мы можем за минуты делать то, что авторы работы DeepCube делали за 40 часов на многих GPU.

Минимальное требование - Вы знакомы с Питоном, и у Вас есть несколько часов свободного времени в неделю. (Альтернативно - можно не знать Питон, но хорошо знать теорию групп (в идеале GAP,SAGE).) Задача проекта - применить машинное обучение к теории групп. Целью проекта является написание статьи в хорошем журнале, участники - соавторы. Другим бонусом будет являться - приобретение навыков по современным методам нейронных сетей, Reinforcement Learning и т.д.

Если Вам интересно участие - напишите @alexander_v_c (Александр Червов, к.ф.-м.н. мехмат МГУ, 25 лет math&DS, Kaggle, Scholar, Linkedin).

Чат для обсуждений: тут .

Вводный доклад тут.

Пояснения по RL части тут.

Краткая суть задачи может быть описана несколькими способами - нахождение пути на графе от вершины А до вершины Б, но размер графа 10^20-10^50 - обычные методы не применимы. Решение пазла типа Кубика Рубика. Задача близка к прошедшему конкурсу Каггл Санта 2023. Математически - разложение элемента группы по образующим. Математические пакеты, которые частично могут решать эту задачу - GAP,SAGE.

Достигнутые результаты - уже сейчас мы можем за минуты делать то, что авторы работы DeepCube делали за 40 часов на многих GPU.

Самое первое (?) или одно из самых первых исторических изображений графиков зависимости объема единичного n-шара (кривая "content") и площади поверхности (кривая "boundary") от размерности. График выполнен в выпускной магистерской работе Paul Renno Heyl в 1897 г. Характерный пик на размерности 5, после которой объем шара устремляется к нулю.

https://mathoverflow.net/questions/128786/history-of-the-high-dimensional-volume-paradox

https://mathoverflow.net/questions/128786/history-of-the-high-dimensional-volume-paradox

Empty Set of Ideas

Самое первое (?) или одно из самых первых исторических изображений графиков зависимости объема единичного n-шара (кривая "content") и площади поверхности (кривая "boundary") от размерности. График выполнен в выпускной магистерской работе Paul Renno Heyl…

https://mathoverflow.net/questions/5372/dimension-leaps

в продолжение обсуждения "the high-dimensional volume paradox" еще много похожих примеров, например, что отношение объема красного шара в центре к объему куба устремляется к +infinity после d=1206 (потому что радиус красного шара зависит от размерности и равен sqrt(d) -1, вылезая из куба после d=10)

в продолжение обсуждения "the high-dimensional volume paradox" еще много похожих примеров, например, что отношение объема красного шара в центре к объему куба устремляется к +infinity после d=1206 (потому что радиус красного шара зависит от размерности и равен sqrt(d) -1, вылезая из куба после d=10)

"Persistent Homology for High-dimensional Data Based on Spectral Methods"

С ростом размерности объемлющего пространства “размывающий эффект” высокоразмерного шума в данных растет, сказываясь на возможностях персистентных гомологий искать инварианты, свойственные латентному многообразию. В данной работе решили посмотреть, как устойчивость персистентных гомологий к высокоразмерному шуму зависит от метрики, используемой в построении комплекса и его фильтрации. Собственно, самыми устойчивыми к шуму оказались спектральные метрики типа diffusion distance и effective resistance distance – своего рода развитие работы М.Белкина про Laplacian eigenmaps, где по собственным векторам лапласиана находились некоторые оптимальные координаты вложения латнетного низкоразмерного многообразия в евклидово пространство размерности n, где n – число старших собственных векторов лапласиана, начиная со второго. Тестировали в основном на S^1, S^2 и T^2 в R^50 и некоторых реальных датасетах. Вопрос, который возник у меня, пока я это читал: они же все равно использовали kNN в R^50 с евклидовой метрикой, чтобы потом посчитать лапласиан полученного графа и только затем спектральные метрики..

“This makes spectral distances on the kNN graph the ideal input to persistent homology for detecting the topology of data in high-dimensional spaces. Indeed, the MDS embedding of the effective resistance and of the diffusion distance of the circle in ambient R^50 both clearly show the circular structure”

Интересно, как быть, если латентное многообразие все-таки имеет размерность сильно большую 2-3

С ростом размерности объемлющего пространства “размывающий эффект” высокоразмерного шума в данных растет, сказываясь на возможностях персистентных гомологий искать инварианты, свойственные латентному многообразию. В данной работе решили посмотреть, как устойчивость персистентных гомологий к высокоразмерному шуму зависит от метрики, используемой в построении комплекса и его фильтрации. Собственно, самыми устойчивыми к шуму оказались спектральные метрики типа diffusion distance и effective resistance distance – своего рода развитие работы М.Белкина про Laplacian eigenmaps, где по собственным векторам лапласиана находились некоторые оптимальные координаты вложения латнетного низкоразмерного многообразия в евклидово пространство размерности n, где n – число старших собственных векторов лапласиана, начиная со второго. Тестировали в основном на S^1, S^2 и T^2 в R^50 и некоторых реальных датасетах. Вопрос, который возник у меня, пока я это читал: они же все равно использовали kNN в R^50 с евклидовой метрикой, чтобы потом посчитать лапласиан полученного графа и только затем спектральные метрики..

“This makes spectral distances on the kNN graph the ideal input to persistent homology for detecting the topology of data in high-dimensional spaces. Indeed, the MDS embedding of the effective resistance and of the diffusion distance of the circle in ambient R^50 both clearly show the circular structure”

Интересно, как быть, если латентное многообразие все-таки имеет размерность сильно большую 2-3