Forwarded from SuperDuperAi

This media is not supported in your browser

VIEW IN TELEGRAM

This media is not supported in your browser

VIEW IN TELEGRAM

This media is not supported in your browser

VIEW IN TELEGRAM

This media is not supported in your browser

VIEW IN TELEGRAM

This media is not supported in your browser

VIEW IN TELEGRAM

This media is not supported in your browser

VIEW IN TELEGRAM

Демо-версия продукта, уже можно переходить по ссылке и тестить. https://demo.superduperai.co

Как это работает?

Добавили выбор шаблона: история, стартап, музыкальный клир, образовательное видео, сказки, недвижимость, кастомное видео.

Выбираете шаблон, пишите промпт и получаете готовый скрипт с актами и сценами. Если вас не устраивает сценарий, его можно отредактировать прямо на месте.

Дальше выбираете длительность готового видео, формат и скорость воспроизведения.

Можно загрузить фото и получить героя с вашим лицом. Или фото стиля, и получить видео в этом стиле.

Далее запустите процесс генерации видео и получите готовое видео. Пока на этой же странице, поэтому не закрывайте ее. Ждать придется 5-7 минут.

🔗 Попробуйте демо-версию сейчас!

Обратную связь не забудьте оставить в комментариях.

* Обязательна регистрация на сайте.

** Если хотите сделать несколько видео одновременно, можно просто открыть несколько вкладок, даже в одном браузере и делать нужное количество видео.

Go, эксперементировать!

Как это работает?

Добавили выбор шаблона: история, стартап, музыкальный клир, образовательное видео, сказки, недвижимость, кастомное видео.

Выбираете шаблон, пишите промпт и получаете готовый скрипт с актами и сценами. Если вас не устраивает сценарий, его можно отредактировать прямо на месте.

Дальше выбираете длительность готового видео, формат и скорость воспроизведения.

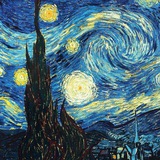

Можно загрузить фото и получить героя с вашим лицом. Или фото стиля, и получить видео в этом стиле.

Далее запустите процесс генерации видео и получите готовое видео. Пока на этой же странице, поэтому не закрывайте ее. Ждать придется 5-7 минут.

🔗 Попробуйте демо-версию сейчас!

Обратную связь не забудьте оставить в комментариях.

* Обязательна регистрация на сайте.

** Если хотите сделать несколько видео одновременно, можно просто открыть несколько вкладок, даже в одном браузере и делать нужное количество видео.

Go, эксперементировать!

Forwarded from Machinelearning

Kolors — это большая диффузионная модель, опубликованная вчера командой Kuaishou Kolors.

Kolors была обучена на миллиардах пар "текст-изображение" и показывает отличные результаты в генерации сложных фотореалистичных изображений.

По результатам оценки 50 независимых экспертов, модель Kolors генерирует более реалистчиные и красивые изображения, чем Midjourney-v6, Stable Diffusion 3, DALL-E 3 и другие модели

@ai_machinelearning_big_data

Please open Telegram to view this post

VIEW IN TELEGRAM

Forwarded from эйай ньюз

🔥Mastering LLMs: Открытый курс по LLM от практиков

Я заметил, что очень хорошо разлетелся пост с ноутбуком для файнтюна LLaMa 3.1 в колабе. Поэтому принес вам еще имбовый курс по LLM от практиков для практиков. Он будет актуален для технических специалистов (включая инженеров и DS-ов), которые имеют некоторый опыт работы с LLM, да, я думаю, и для начинающих практиков он тоже хорошо зайдет.

Это набор лекций, которые покрывают такие прикладные темы как RAG, файн-тюнинг, промпт-инжиниринг, оценка качества моделей и прочее. Курс уникальный, потому что лекции ведут 25+ разных опытных чуваков из индустрии, которые являются экспертами по соответсвующим темам. Там ребята из Pytorch (Meta), Anthropic, Mistral, Fireworks-ai и других компаний.

Курс очень хорошо оформлен. К каждой лекции идут слайды, заметки, дополнительные ресурсы со ссылками и полный транскрипт видео.

Минимальные требования, чтобы успешно смотреть курс:

- Базовое знакомство с LLM-ками.

- Если такого опыт у вас нет, то рекомендуется начать с видео A Hacker’s Guide to LLMs от Джереми Ховарда, а также пройти туториал об Instruction Tuning LlaMa-2.

> Ссылка на курс: https://parlance-labs.com/education/

Давайте еще накидаем в комментах другие классные курсы по NLP, которые вы сами смотрели/проходили.

#ликбез

@ai_newz

Я заметил, что очень хорошо разлетелся пост с ноутбуком для файнтюна LLaMa 3.1 в колабе. Поэтому принес вам еще имбовый курс по LLM от практиков для практиков. Он будет актуален для технических специалистов (включая инженеров и DS-ов), которые имеют некоторый опыт работы с LLM, да, я думаю, и для начинающих практиков он тоже хорошо зайдет.

Это набор лекций, которые покрывают такие прикладные темы как RAG, файн-тюнинг, промпт-инжиниринг, оценка качества моделей и прочее. Курс уникальный, потому что лекции ведут 25+ разных опытных чуваков из индустрии, которые являются экспертами по соответсвующим темам. Там ребята из Pytorch (Meta), Anthropic, Mistral, Fireworks-ai и других компаний.

Курс очень хорошо оформлен. К каждой лекции идут слайды, заметки, дополнительные ресурсы со ссылками и полный транскрипт видео.

Минимальные требования, чтобы успешно смотреть курс:

- Базовое знакомство с LLM-ками.

- Если такого опыт у вас нет, то рекомендуется начать с видео A Hacker’s Guide to LLMs от Джереми Ховарда, а также пройти туториал об Instruction Tuning LlaMa-2.

> Ссылка на курс: https://parlance-labs.com/education/

Давайте еще накидаем в комментах другие классные курсы по NLP, которые вы сами смотрели/проходили.

#ликбез

@ai_newz

Forwarded from эйай ньюз

Ядро команды состоит из авторов Stable Diffusion, которые покинули Stability-ai в марте. Как я и думал, они ушли и создали свою компанию!

Парни за эти несколько месяцев обучили text2image модель FLUX.1 на 12 B параметров! Которая на сегодня является SOTA моделью в открытом доступе! По предоставленным бенчам бьет даже MJ6!

Кажется, делали FLUX.1 по рецепту SD3, т.к. она имеет очень похожую архитектуру (DiT с двумя стримами - текст и картинка) и также основана на Flow Matching.

FLUX.1 вышла в 3 вариантах:

Доступна только через API:

- https://replicate.com/black-forest-labs

- https://fal.ai/models/fal-ai/flux-pro (дают даже бесплатно потыкать)

Демо:

- https://fal.ai/models/fal-ai/flux/dev

Веса (Non-Commercial License):

- https://huggingface.co/black-forest-labs/FLUX.1-dev

Веса (Apache 2.0 License):

- https://huggingface.co/black-forest-labs/FLUX.1-schnell

Репа с кодом

Блогпост

Следуюшим шагом парни хотят выпустить SOTA text2video в опенсорс.

@ai_newz

Please open Telegram to view this post

VIEW IN TELEGRAM

Please open Telegram to view this post

VIEW IN TELEGRAM

Forwarded from Технологии | Нейросети | Боты

This media is not supported in your browser

VIEW IN TELEGRAM

Babelfish — нейросеть на базе OpenAI Whisper, которая быстро и точно распознает речь и переведет её на 200 языков с помощью Meta's NLLB-200. И всё это прямо в браузере.

• Попробовать

• Github

#neural #нейросети

@aiaiai

Please open Telegram to view this post

VIEW IN TELEGRAM

Forwarded from Технологии | Нейросети | Боты

This media is not supported in your browser

VIEW IN TELEGRAM

BiRefNet — новый инструмент для быстрого удаления фона. Разработчики утверждают, что он на голову лучше конкурентов.

Проверить самим можно уже сейчас, бесплатно и без лимитов.

• Github

• Попробовать

#neural #нейросети

@aiaiai

Please open Telegram to view this post

VIEW IN TELEGRAM

Forwarded from Machinelearning

Clapper - это инструмент визуализации историй, разрабатываемый как пет-проект сотрудником Huggingface Julian Bilcke

Созданный год назад, Clapper не предназначен для замены традиционных видеоредакторов или AI-редакторов, использующих 3D-сцены в качестве исходного материала.

Философия Clapper заключается в том, чтобы каждый мог создавать видео с помощью GenAI-инструментов посредством интерактивного, итеративного и интуитивного процесса, без необходимости использования разных интерфейсов, навыков режиссуры или AI-инженерии.

В Clapper вы не редактируете последовательность видео- и аудиофайлов напрямую, а итерируете (с помощью вашего помощника ИИ) свою историю, используя высокоуровневые абстракции, такие как персонажи, места, погода, временной период, стиль и т. д.

Конечной целью проекта заявлен полностью режиссерский режим, с которым вы можете просто перевести видео в полноэкранный режим, удобно расположиться в режиссерском кресле (или на диване) и, произнося голосом команды своему AI-ассистенту для создания вашего фильма, насладитесь созданным лично Вами шедевром.

⚠️ Это альфа-версия инструмента, который разрабатывают 3 человека. Не стоит ожидать от этого открытого проекта революционных результатов.

Clapper поддерживает интеграцию по API с локальными системами (ComfyUI) и он-лайн сервисами:

HuggingFace, Replicate, ComfuICU, FalAI, ModelsLab, OpenAI, Groq, Google, Anthropic, Cohere, MistralAI, StabilityAI, ElevenLabs, KitsAI.

Проект написан на TypeScript. Необходимые условия перед установкой:

# Install the dependencies:

# --include=optional to make

# sure deps are installed

bun i

# build the app:

npm run build

# Running the web app:

bun run dev

# first time you go to localhost:3000

# Wait around 1 minute, the app will compile

cd packages/app

bun run electron:start

# You can also build Clapper:

cd packages/app

bun run electron:make

@ai_machinelearning_big_data

#AI #Storytelling #Clapper #Visialtool

Please open Telegram to view this post

VIEW IN TELEGRAM

Please open Telegram to view this post

VIEW IN TELEGRAM

Forwarded from эйай ньюз

А вот и первый IP-Adapter для FLUX.1 [dev] подъехал

IP-adapter - это штука, которая позволяет подавать в модель кроме текста еще и референсную картинку. По умолчанию Flux картинку на вход не принимает.

Подробнее про устройство IP-Adapter, и как он используется, например, в Midjourney я писал тут.

Тут используют openai/clip-vit-large в качестве энкодера изображений и подмешивают эти токены в модифицированный cross-attention.

Тренили его на 512x512 в течение 50k шагов и на 1024x1024 в течение 25k шагов. Во время инференса работает и в 512x512 и в 1024x1024.

Это только первая версия адаптера, поэтому может быть еще сыровата.

Веса на HF

Воркфлоу для Comfy UI

@ai_newz

IP-adapter - это штука, которая позволяет подавать в модель кроме текста еще и референсную картинку. По умолчанию Flux картинку на вход не принимает.

Подробнее про устройство IP-Adapter, и как он используется, например, в Midjourney я писал тут.

Тут используют openai/clip-vit-large в качестве энкодера изображений и подмешивают эти токены в модифицированный cross-attention.

Тренили его на 512x512 в течение 50k шагов и на 1024x1024 в течение 25k шагов. Во время инференса работает и в 512x512 и в 1024x1024.

Это только первая версия адаптера, поэтому может быть еще сыровата.

Веса на HF

Воркфлоу для Comfy UI

@ai_newz

Forwarded from SuperDuperAi

Подключили новый мощный движок Flux от Blackforest Labs для генерации видео с помощью ИИ! Мы только что выкатили его в общий доступ на неделю, так что заходите и тестируйте 🔥

⚙️ Flux — это cutting-edge инструмент для генерации фотографии. За счет уникальной архитектуры и интеграции с нашими алгоритмами, мы смогли поднять производительность на новый уровень. Результат? Быстрее, умнее, качественнее.

⚡️ Заходите, тестируйте

https://demo.superduperai.co/

⚙️ Flux — это cutting-edge инструмент для генерации фотографии. За счет уникальной архитектуры и интеграции с нашими алгоритмами, мы смогли поднять производительность на новый уровень. Результат? Быстрее, умнее, качественнее.

⚡️ Заходите, тестируйте

https://demo.superduperai.co/