Forwarded from Нейроинтерфейсы (Sergei Shishkin)

Международная конференция по когнитому в Вышке

Computer Methods of Cognitome Analysis

September 1-3, 2022

Участие бесплатное, но нужно зарегистрироваться.

Дедлайн для регистрации: 30 августа

Место проведения:

- Москва, Покровский бульвар, 11

- а также онлайн

https://cs.hse.ru/ata-lab/cmca/

Computer Methods of Cognitome Analysis

September 1-3, 2022

Участие бесплатное, но нужно зарегистрироваться.

Дедлайн для регистрации: 30 августа

Место проведения:

- Москва, Покровский бульвар, 11

- а также онлайн

https://cs.hse.ru/ata-lab/cmca/

cs.hse.ru

International Conference "Computer Methods of Cognitome Analysis"

Forwarded from Нейроинтерфейсы (Sergei Shishkin)

Фейсбук попытался декодировать речь по МЭГ и ЭЭГ

На днях мы в очередной раз стебались над Цукербергом в связи с его новым интервью. Напомним, он сначала обещал прямую конвертацию мыслей в посты в (забаненном в России) Фейсбуке со скоростью 100 слов в минуту, а когда ничего не получилось, купил за полмиллиарда долларов (если не больше) стартап, пытающийся сделать набор текста по активации мышц, и начал называть эту технологию "нейроинтерфейсом" -- впрочем, и в этом направлении что-то не видно продвижения.

Как оказалось, к моменту выхода в Buiseness Insider обсуждавшегося нами материала исследователи из Meta AI (Мета забанена в РФ) уже выложили препринт, в котором на сей раз попытались декодировать речь по МЭГ и даже (хотя и хуже) по ЭЭГ из больших публичных датасетов:

The results show that our model can identify, from 3s of MEG signals, the corresponding speech segment with up to 72.5% top-10 accuracy out of 1,594 distinct segments (and 44% top-1 accuracy), and up to 19.1% out of 2,604 segments for EEG recordings– hence allowing the decoding of phrases absent from the training set.

our model extracts the deep contextual representations of 3s speech signals (Y) from a pretrained self-supervised model (wav2vec 2.0: Baevski et al. [2020]) and learns the representations Z of the brain activity on the corresponding 3s window (X) that maximally align with these speech representations with a contrastive loss (CLIP: Radford et al. [2021]). The representation Z is given by a deep convolutional network. At evaluation, we input the model with left-out sentences and compute the probability of each 3s speech segment given each brain representation. The resulting decoding can thus be “zero-shot” in that the audio snippets predicted by the model need not be present in the training set. This approach is thus more general than standard classification approaches where the decoder can only predict the categories learnt during training.

Alexandre Défossez, Charlotte Caucheteux, Jérémy Rapin, Ori Kabeli, Jean-Rémi King. Decoding speech from non-invasive brain recordings. arXiv:2208.12266, 25 Aug 2022 https://doi.org/10.48550/arXiv.2208.12266

Популярное изложение:

Using AI to decode speech from brain activity

August 31, 2022

https://ai.facebook.com/blog/ai-speech-brain-activity/

Все бы хорошо, но вот только нет никакого практического смысла в самом по себе декодировании мозговой активности при прослушивании аудиокниг -- именно такой материал использовался здесь. А мозговая активность при мысленной речи -- которую, собственно, фейсбуковцы планируют использовать в интерфейсе мозг-компьютер -- на нее очень мало похожа. Сенсорные стимулы -- мощнейшие детерминанты ЭЭГ и МЭГ, и ответ на них во времени очень четко привязан к звуку, особенно к его физическим характеристикам, прежде всего к модуляции громкости. Увы, в мысленной речи нет таких удобных зацепок.

Посмотрим, может быть, какое-то применение этим результатам со временем все же найдется. На данный момент перед нами лишь очередной сферический конь в вакууме.

Напомним, хотя в последнее время выходит много публикаций, в которых якобы удается "декодировать" внутреннюю (мысленную) речь по неинвазивным ЭЭГ или МЭГ, специалисты очень скептически относятся к возможности это делать. Всякий раз при внимательном рассмотрении обнаруживается, что либо артефакты в данных не контролировались (а они в таких задачах возникают очень легко и могут очень сильно влиять на результаты), либо авторы и вовсе недостаточно аккуратно организовали получение данных или валидацию результатов.

На днях мы в очередной раз стебались над Цукербергом в связи с его новым интервью. Напомним, он сначала обещал прямую конвертацию мыслей в посты в (забаненном в России) Фейсбуке со скоростью 100 слов в минуту, а когда ничего не получилось, купил за полмиллиарда долларов (если не больше) стартап, пытающийся сделать набор текста по активации мышц, и начал называть эту технологию "нейроинтерфейсом" -- впрочем, и в этом направлении что-то не видно продвижения.

Как оказалось, к моменту выхода в Buiseness Insider обсуждавшегося нами материала исследователи из Meta AI (Мета забанена в РФ) уже выложили препринт, в котором на сей раз попытались декодировать речь по МЭГ и даже (хотя и хуже) по ЭЭГ из больших публичных датасетов:

The results show that our model can identify, from 3s of MEG signals, the corresponding speech segment with up to 72.5% top-10 accuracy out of 1,594 distinct segments (and 44% top-1 accuracy), and up to 19.1% out of 2,604 segments for EEG recordings– hence allowing the decoding of phrases absent from the training set.

our model extracts the deep contextual representations of 3s speech signals (Y) from a pretrained self-supervised model (wav2vec 2.0: Baevski et al. [2020]) and learns the representations Z of the brain activity on the corresponding 3s window (X) that maximally align with these speech representations with a contrastive loss (CLIP: Radford et al. [2021]). The representation Z is given by a deep convolutional network. At evaluation, we input the model with left-out sentences and compute the probability of each 3s speech segment given each brain representation. The resulting decoding can thus be “zero-shot” in that the audio snippets predicted by the model need not be present in the training set. This approach is thus more general than standard classification approaches where the decoder can only predict the categories learnt during training.

Alexandre Défossez, Charlotte Caucheteux, Jérémy Rapin, Ori Kabeli, Jean-Rémi King. Decoding speech from non-invasive brain recordings. arXiv:2208.12266, 25 Aug 2022 https://doi.org/10.48550/arXiv.2208.12266

Популярное изложение:

Using AI to decode speech from brain activity

August 31, 2022

https://ai.facebook.com/blog/ai-speech-brain-activity/

Все бы хорошо, но вот только нет никакого практического смысла в самом по себе декодировании мозговой активности при прослушивании аудиокниг -- именно такой материал использовался здесь. А мозговая активность при мысленной речи -- которую, собственно, фейсбуковцы планируют использовать в интерфейсе мозг-компьютер -- на нее очень мало похожа. Сенсорные стимулы -- мощнейшие детерминанты ЭЭГ и МЭГ, и ответ на них во времени очень четко привязан к звуку, особенно к его физическим характеристикам, прежде всего к модуляции громкости. Увы, в мысленной речи нет таких удобных зацепок.

Посмотрим, может быть, какое-то применение этим результатам со временем все же найдется. На данный момент перед нами лишь очередной сферический конь в вакууме.

Напомним, хотя в последнее время выходит много публикаций, в которых якобы удается "декодировать" внутреннюю (мысленную) речь по неинвазивным ЭЭГ или МЭГ, специалисты очень скептически относятся к возможности это делать. Всякий раз при внимательном рассмотрении обнаруживается, что либо артефакты в данных не контролировались (а они в таких задачах возникают очень легко и могут очень сильно влиять на результаты), либо авторы и вовсе недостаточно аккуратно организовали получение данных или валидацию результатов.

Meta

Using AI to decode speech from brain activity

Decoding speech from brain activity has mostly benefited from invasive approaches. New research from FAIR shows AI could instead make use of noninvasive brain scans.

Forwarded from Нейроинтерфейсы (Sergei Shishkin)

Датасет с МЭГ, записанной при прослушивании речи

Данные:

https://osf.io/ag3kj/

Препринт:

Laura Gwilliams, Graham Flick, Alec Marantz, Liina Pylkkanen, David Poeppel, Jean-Remi King. MEG-MASC: a high-quality magneto-encephalography dataset for evaluating natural speech processing. arXiv:2208.11488, 26 Jul 2022 https://doi.org/10.48550/arXiv.2208.11488

По-видимому, именно этот датасет упоминается в недавней статье исследователей из ФБ, забаненного в РФ, "расшифровавших" речь по МЭГ, как Gwilliams2022 (ссылка не была расшифрована в статье).

Данные:

https://osf.io/ag3kj/

Препринт:

Laura Gwilliams, Graham Flick, Alec Marantz, Liina Pylkkanen, David Poeppel, Jean-Remi King. MEG-MASC: a high-quality magneto-encephalography dataset for evaluating natural speech processing. arXiv:2208.11488, 26 Jul 2022 https://doi.org/10.48550/arXiv.2208.11488

По-видимому, именно этот датасет упоминается в недавней статье исследователей из ФБ, забаненного в РФ, "расшифровавших" речь по МЭГ, как Gwilliams2022 (ссылка не была расшифрована в статье).

👍1

https://www.meetup.com/coglab/events/szgmxsydcmbzb/

HackNight NeuroTechX Paris

Mon, Sep 19 · 6:40 PM CEST, 19:40 MSK

HackNight NeuroTechX Paris

Mon, Sep 19 · 6:40 PM CEST, 19:40 MSK

Meetup

Login to Meetup | Meetup

Find groups that host online or in person events and meet people in your local community who share your interests.

Forwarded from Институт высшей нервной деятельности и нейрофизиологии РАН

Уважаемые коллеги!

Публикуем программу XXVI научной школы-конференции молодых ученых по физиологии высшей нервной деятельности и нейрофизиологии.

Конференция состоится 26-27 октября в ИВНД и НФ РАН в очном и онлайн-формате.

Приглашаем вас принять участие в Конференции лично или онлайн в качестве слушателей.

Подключиться к конференции Zoom

https://us02web.zoom.us/j/86381900813?pwd=dW1kNk1SWHRMemNlMXNBUEFGYlNpUT09

Идентификатор конференции: 863 8190 0813

Код доступа: 379106

Публикуем программу XXVI научной школы-конференции молодых ученых по физиологии высшей нервной деятельности и нейрофизиологии.

Конференция состоится 26-27 октября в ИВНД и НФ РАН в очном и онлайн-формате.

Приглашаем вас принять участие в Конференции лично или онлайн в качестве слушателей.

Подключиться к конференции Zoom

https://us02web.zoom.us/j/86381900813?pwd=dW1kNk1SWHRMemNlMXNBUEFGYlNpUT09

Идентификатор конференции: 863 8190 0813

Код доступа: 379106

Zoom Video

Join our Cloud HD Video Meeting

Zoom is the leader in modern enterprise video communications, with an easy, reliable cloud platform for video and audio conferencing, chat, and webinars across mobile, desktop, and room systems. Zoom Rooms is the original software-based conference room solution…

Forwarded from Olga

ПРОГРАММА_КМУ_26.10.-27.10.2022.pdf

249.1 KB

Forwarded from Нейроинтерфейсы (Sergei Shishkin)

Магнитоэнцефалография: от клиники до фундаментальной науки

Беседа Марины Аствацатурян с директором Центра биоэлектрических интерфейсов ВШЭ Алексеем Осадчим на Первом медицинском канале

https://youtu.be/u69BlmWFzKs

• О методе МЭГ и его преимуществах

• О возможностях новейших компактных магнитометров с оптической накачкой (OPM MEG), которые можно ставить прямо на голову

• О созданном Алексеем и его коллегами одном из первых в мире нейроинтерфейсе на основе OPM MEG

• О применении МЭГ для диагностики и исследования эпилепсии

• Об экспериментальных исследованиях с использованием МЭГ, развивающих висцеральную теорию сна И.Н. Пигарева

Алексей в последние годы больше всего известен как один из ведущих российских экспертов по интерфейсам мозг-компьютер. Но он также является и ведущим российским специалистом по физике МЭГ-сигнала, так что эту беседу очень стоит послушать!

Кстати, в следующий четверг ожидается его лекция в открытом курсе МГУ "Нейроинтерфейсы: от биологии до анализа данных".

Беседа Марины Аствацатурян с директором Центра биоэлектрических интерфейсов ВШЭ Алексеем Осадчим на Первом медицинском канале

https://youtu.be/u69BlmWFzKs

• О методе МЭГ и его преимуществах

• О возможностях новейших компактных магнитометров с оптической накачкой (OPM MEG), которые можно ставить прямо на голову

• О созданном Алексеем и его коллегами одном из первых в мире нейроинтерфейсе на основе OPM MEG

• О применении МЭГ для диагностики и исследования эпилепсии

• Об экспериментальных исследованиях с использованием МЭГ, развивающих висцеральную теорию сна И.Н. Пигарева

Алексей в последние годы больше всего известен как один из ведущих российских экспертов по интерфейсам мозг-компьютер. Но он также является и ведущим российским специалистом по физике МЭГ-сигнала, так что эту беседу очень стоит послушать!

Кстати, в следующий четверг ожидается его лекция в открытом курсе МГУ "Нейроинтерфейсы: от биологии до анализа данных".

YouTube

«Магнитоэнцефалография: от клиники до фундаментальной науки». Гость: Осадчий А.Е.

В новом выпуске авторской программы Марины Аствацатурян «Медицина в контексте» мы продолжим тему изучения нейроинтерфейсов «мозг-компьютер» и их терапевтических возможностей, основанных на фундаментальных свойствах нервной системы и нервной ткани.

Чтобы…

Чтобы…

QZFM Gen-3

Field Sensitivity:

Dual Axis Variant: <15 fT/√Hz in 3-100 Hz band (typical 7-10 fT/√Hz)

Triax Variant: <23 fT/√Hz in 3-100 Hz band (typical 15 fT/√Hz all axis simultaneous)

Dynamic Range: ±5 nT

Pricing per sensor (USD):

Qty 1-3: $10,000

Qty 4-7: $8,500

Qty 8-15: $8,000

Qty 16-32: $7,700

https://quspin.com/products-qzfm/

https://quspin.com/products-qzfm-gen2-arxiv/

https://quspin.com/qzfm-gen-2-update/

https://groups.google.com/d/forum/qzfm-discussion-board

Field Sensitivity:

Dual Axis Variant: <15 fT/√Hz in 3-100 Hz band (typical 7-10 fT/√Hz)

Triax Variant: <23 fT/√Hz in 3-100 Hz band (typical 15 fT/√Hz all axis simultaneous)

Dynamic Range: ±5 nT

Pricing per sensor (USD):

Qty 1-3: $10,000

Qty 4-7: $8,500

Qty 8-15: $8,000

Qty 16-32: $7,700

https://quspin.com/products-qzfm/

https://quspin.com/products-qzfm-gen2-arxiv/

https://quspin.com/qzfm-gen-2-update/

https://groups.google.com/d/forum/qzfm-discussion-board

Forwarded from Нейроинтерфейсы (Sergei Shishkin)

Вакансия в МЭГ-центре

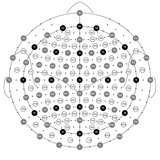

В единственном в России исследовательском центре, изучающем мозг человека с помощью собственной 306-канальной магнитоэнцефалографической системы (Neuromag Vectorview) – Московском МЭГ-центре ( http://megmoscow.ru/ ) – открыта вакансия исследователя-стажера, участвующего в экспериментальных исследованиях когнитивных способностей человека.

Основные обязанности:

• Подготовка стимульных материалов для проведения экспериментов

• Поиск испытуемых для экспериментов

• Регистрация активности головного мозга с использованием магнитоэнцефалографа

• Обработка МЭГ-данных с помощью набора программных пакетов

Что мы ждем от успешного кандидата:

• Базовые знания по физиологии высшей нервной деятельности

• Навыки программирования

• Высшее образование или обучение в магистратуре вуза

• Владение английским языком на уровне intermediate и выше

Что мы предлагаем:

• Уникальный опыт участия в научных проектах международного уровня

• Научные публикации в ведущих научных изданиях

• Взаимодействие с ведущими зарубежными научными центрами с последующей возможностью поступления на PhD программы в них

• Гибкий график работы

• Для студентов – возможность совмещать работу с выполнением выпускных работ под руководством сотрудников МЭГ-центра

• Заработная плата 25-50 тысяч рублей (зависит от степени занятости и опыта)

Обращайтесь к Владимиру Козунову – kozunov.vladimir@gmail.com

В единственном в России исследовательском центре, изучающем мозг человека с помощью собственной 306-канальной магнитоэнцефалографической системы (Neuromag Vectorview) – Московском МЭГ-центре ( http://megmoscow.ru/ ) – открыта вакансия исследователя-стажера, участвующего в экспериментальных исследованиях когнитивных способностей человека.

Основные обязанности:

• Подготовка стимульных материалов для проведения экспериментов

• Поиск испытуемых для экспериментов

• Регистрация активности головного мозга с использованием магнитоэнцефалографа

• Обработка МЭГ-данных с помощью набора программных пакетов

Что мы ждем от успешного кандидата:

• Базовые знания по физиологии высшей нервной деятельности

• Навыки программирования

• Высшее образование или обучение в магистратуре вуза

• Владение английским языком на уровне intermediate и выше

Что мы предлагаем:

• Уникальный опыт участия в научных проектах международного уровня

• Научные публикации в ведущих научных изданиях

• Взаимодействие с ведущими зарубежными научными центрами с последующей возможностью поступления на PhD программы в них

• Гибкий график работы

• Для студентов – возможность совмещать работу с выполнением выпускных работ под руководством сотрудников МЭГ-центра

• Заработная плата 25-50 тысяч рублей (зависит от степени занятости и опыта)

Обращайтесь к Владимиру Козунову – kozunov.vladimir@gmail.com

Forwarded from АРПЭ

Впервые в России силами специалистов ФИАНа и малых коммерческих компаний разработан магнитно-резонансный томограф, готовый к серийному производству. Руководитель разработки Евгений Демихов рассказывает о ее истории, а также о проблемах научного-приборостроения и импортозамещения

https://stimul.online/articles/science-and-technology/ot-nauki-k-biznesu-na-nauke-i-obratno-put-uchenogo/

https://stimul.online/articles/science-and-technology/ot-nauki-k-biznesu-na-nauke-i-obratno-put-uchenogo/

stimul.online

От науки к бизнесу на науке и обратно: путь ученого

Впервые в России силами специалистов ФИАНа и малых коммерческих компаний разработан магнитно-резонансный томограф, готовый к серийному производству. Руководитель разработки Евгений Демихов рассказывает о ее истории, а также о проблемах научного-приборостроения…

👍1

Forwarded from AbstractDL

MinD-Vis: диффузия для чтения мыслей

Представлена диффузионная модель, которая умеет декодировать то, что видит человек по его мозговой активности (fMRI).

Сначала авторы обучили self-supervised модель для получения универсальных эмбеддингов мозговой активности (одинаковых для разных людей). Далее они взяли предобученную Latent Diffusion и добавили к ней cross-attention на эти мысленные репрезентации. После короткого файнтюна на 1.5к парах картинка-fMRI модель смогла полноценно декодировать то, что видит перед собой человек!

Данные для обучения и код выложены в открытый доступ, веса моделей дают по запросу.

Статья, GitHub, блог

Представлена диффузионная модель, которая умеет декодировать то, что видит человек по его мозговой активности (fMRI).

Сначала авторы обучили self-supervised модель для получения универсальных эмбеддингов мозговой активности (одинаковых для разных людей). Далее они взяли предобученную Latent Diffusion и добавили к ней cross-attention на эти мысленные репрезентации. После короткого файнтюна на 1.5к парах картинка-fMRI модель смогла полноценно декодировать то, что видит перед собой человек!

Данные для обучения и код выложены в открытый доступ, веса моделей дают по запросу.

Статья, GitHub, блог

EEG and pupillometric signatures of working memory overload

https://www.biorxiv.org/content/10.1101/2022.11.21.517347v1

https://www.biorxiv.org/content/10.1101/2022.11.21.517347v1

Rhythmic temporal coordination of neural activity avoids representational conflict during working memory

https://doi.org/10.1101/2022.12.02.518876

https://doi.org/10.1101/2022.12.02.518876

EEG error-related potentials encode magnitude of errors and individual perceptual thresholds

https://doi.org/10.1101/2022.12.06.519418

https://doi.org/10.1101/2022.12.06.519418

Forwarded from Новости нейронаук и нейротехнологий (Alexey Paevskiy)

Слет участников нейроиндустрии

Инфраструктурный центр по направлению «Нейронет» 3.0 (АНО «Технологии возможностей») проводит серию мероприятий в 2022–2024 годах, направленных на усовершенствование Дорожной карты «Нейронет» и, в целом, на развитие рынка нейротехнологий в России. 19 декабря 2022 года в Москве, в партнерстве с РТУ МИРЭА, состоится Слет участников нейроиндустрии.

Подробности и регистрация:

http://neuronovosti.ru/slet-uchastnikov-nejroindustrii/

Инфраструктурный центр по направлению «Нейронет» 3.0 (АНО «Технологии возможностей») проводит серию мероприятий в 2022–2024 годах, направленных на усовершенствование Дорожной карты «Нейронет» и, в целом, на развитие рынка нейротехнологий в России. 19 декабря 2022 года в Москве, в партнерстве с РТУ МИРЭА, состоится Слет участников нейроиндустрии.

Подробности и регистрация:

http://neuronovosti.ru/slet-uchastnikov-nejroindustrii/